Développement de systèmes basés sur l’intelligence artificielle pour la surveillance de l’état du conducteur et la prévention des risques d’accident

- Contexte : La somnolence au volant constitue l’une des principales causes d’accidents de la route, mettant en danger non seulement le conducteur, mais également les autres usagers. Parmi les signes précurseurs de fatigue, les clignements fréquents des yeux et les bâillements sont des indicateurs physiologiques clés. Dans ce projet, nous explorons l’utilisation de l’intelligence artificielle, et plus particulièrement des architectures de type Transformer, pour détecter automatiquement ces signes à partir de séquences vidéo. Bien que la mise en œuvre de telles méthodes représente un défi en raison de la complexité des données visuelles et de la variabilité des comportements humains, les modèles Transformers offrent un cadre prometteur pour capturer les dynamiques temporelles de la somnolence avec une grande précision.

- Objectif : L’objectif principal de ce projet est de concevoir, implémenter et évaluer un système de détection automatique de la somnolence au volant à partir de séquences vidéo du visage du conducteur, en s’appuyant sur des modèles de type Transformer. Le système visé doit être capable d’identifier de manière fiable les signes comportementaux liés à l’état de somnolence, tels que la fréquence des clignements, la fermeture prolongée des paupières ou les bâillements, à partir d’une analyse dynamique des traits faciaux dans le temps.

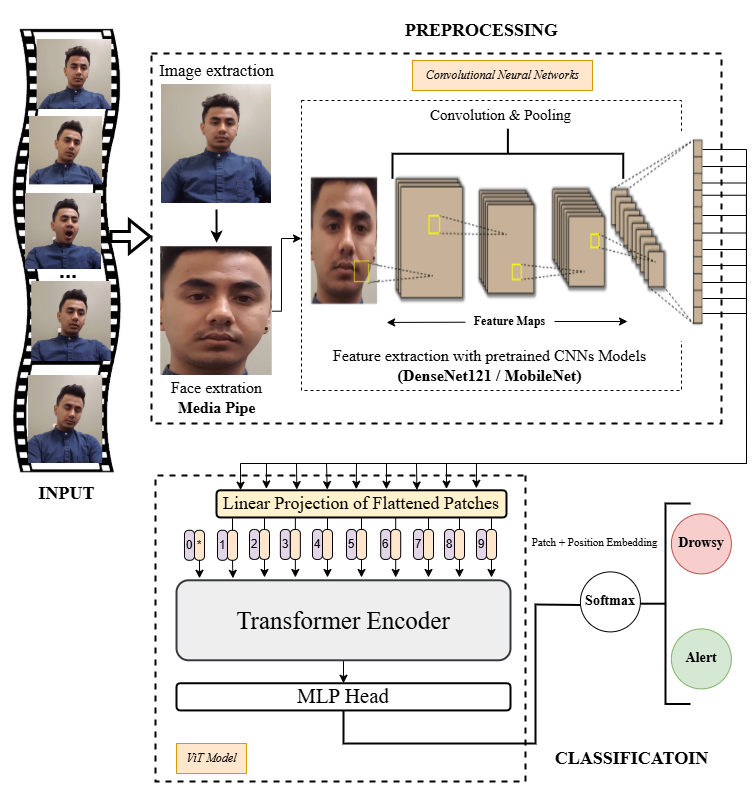

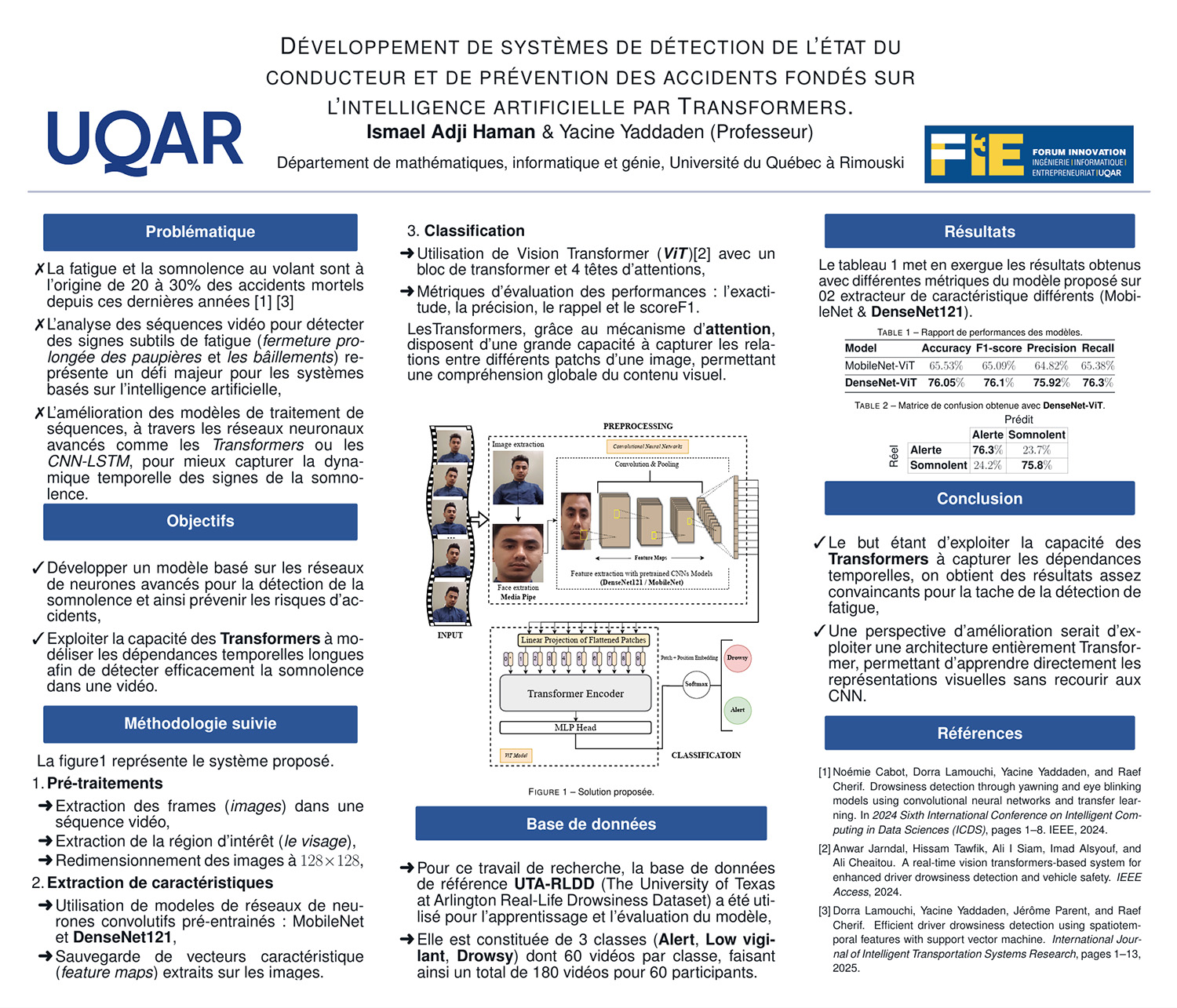

- Méthodologie: Le système proposé repose sur un pipeline modulaire permettant de détecter automatiquement la somnolence à partir de séquences vidéo du visage du conducteur. Il se compose de plusieurs étapes successives, allant du prétraitement des données jusqu’à la classification finale par un modèle Transformer.

- Il commence par l’extraction automatique des visages via MediaPipe, image par image, à partir de vidéos capturées à faible fréquence (1 fps). Chaque visage est ensuite transformé en vecteur de caractéristiques à l’aide d’un réseau convolutif léger tel que MobileNetV2.

- Ces vecteurs sont ensuite regroupés chronologiquement pour former des séquences temporelles, capturant l’évolution des expressions faciales. Ces séquences constituent l’entrée d’un modèle Transformer, chargé de modéliser les dynamiques faciales sur le temps et de classifier chaque séquence selon l’état de vigilance (éveillé ou somnolent).

- Le pipeline est enfin évalué sur des métriques classiques de classification et optimisé en vue d’un déploiement potentiel sur système embarqué.

- Résultats: L’utilisation de MobileNetV2 comme extracteur de caractéristiques a amélioré la détection des signes de somnolence, bien que les performances restent modérées. Le modèle Transformer a permis d’obtenir des résultats corrects en précision et rappel, mais des améliorations sont nécessaires pour renforcer la robustesse et la précision du système.

- Conclusion: Les résultats obtenus sont prometteurs, bien que modérés. Une piste d’amélioration serait de se concentrer uniquement sur les Transformers, en éliminant l’extracteur de caractéristiques séparé. Cela pourrait simplifier le pipeline et potentiellement améliorer les performances en exploitant mieux les dépendances temporelles dans les données faciales.

Présenté par

Ismael Adji Haman, étudiant à la maîtrise en informatique (recherche)

Partenaires